Câmara dos Deputados

Moderação de conteúdo pela redes sociais divide opiniões em debate sobre fake news

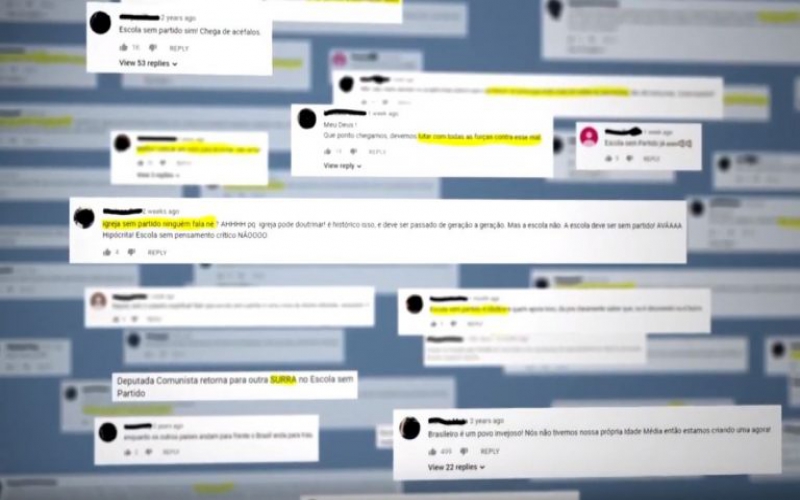

No terceiro dia de debate na Câmara dos Deputados sobre a proposta para coibir a disseminação de fake news na internet (Projeto de Lei 2630/20) não houve consenso sobre as regras previstas para a moderação de conteúdo pelas redes sociais e sobre a melhor forma de coibir ataques à honra nas redes.

O deputado Nereu Crispim (PSL-RS) criticou a possibilidade de anonimato em ataques nas redes sociais, especialmente contra políticos, disse que Justiça é lenta para decidir sobre os ataques à honra pessoal; e acusou as plataformas de não responder de forma efetiva às denúncias de difamação feitas pelos cidadãos.

“Temos que tirar o anonimato. Cidadão de bem não vai ter problema nenhum em ter seus dados lá, só o criminoso vai ter essa preocupação”, opinou. Para ele, para coibir ataques à honra, é preciso divulgar o CPF e a identidade dos usuários.

Gustavo Sales/Câmara dos Deputados

Lei de combate às Fake News. Dep. Nereu Crispim (PSL RS)

Deputado Nereu Crispim quer coibir ataques anônimos à honra

João Guilherme Bastos, do Instituto Nacional de Ciência e Tecnologia em Democracia Digital, no entanto, disse que expor esses dados não vai impedir ataques à honra, e ressaltou que os dados pessoais poderão ser usados para fins ilícitos.

A diretora-executiva do site Aos fatos – plataforma de checagem de informações públicas -, Tai Nalon, foi além e afirmou que “os grandes motores de desinformação na rede não são as ‘tias do zap’, não são os usuários desinformados, mas políticos com mandatos e influência na rede”, com contas verificadas.

Decisão judicial Bia Barbosa, da Coalizão Direitos na Rede, concordou com Nereu Crispim de que a Justiça poderia ser mais célere e ativa. Mas considerou acertada a previsão contida no Marco Civil da Internet de que um provedor de aplicações só pode ser responsabilizado por determinado conteúdo se não cumprir decisão judicial que o obrigue a removê-lo.

Isso não impede que as plataformas tenham suas políticas de uso para remoção de conteúdo.

Ela considerou essencial que seja mantido no texto do projeto de lei o direito de o usuário ser notificado quando um conteúdo de sua autoria for removido pela plataforma, e ressaltou que hoje nem sempre isso é feito pelas empresas.

Além disso, para que a liberdade de expressão não seja violada, ela defendeu a manutenção no texto do direito de o usuário contestar a remoção de um determinado conteúdo e o direito de resposta na mesma medida e alcance do conteúdo considerado inadequado.

Gustavo Sales/Câmara dos Deputados

Lei de combate às Fake News. Public Policy Manager Google, Juliana Nolasco

Juliana Nolasco, do Google, considerou muito detalhadas as regras para remoção de conteúdo

Detalhamento excessivo Alguns especialistas consideraram, porém, muito detalhadas as regras sobre remoção de conteúdo, que estão previstas no artigo 12 da proposta aprovada pelo Senado.

O advogado e professor da UERJ Carlos Affonso Souza foi um dos que manifestou essa preocupação. Ele considerou excessivo, por exemplo, obrigar as plataformas a notificar os usuários não apenas em relação a conteúdos e contas removidas, mas em relação a denúncias recebidas pela plataforma.

Em relação ao direito de resposta, ele observou que algumas plataformas como Wikipedia e YouTube têm hoje formas de moderação descentralizadas, operadas pelo próprio usuário – os youtubers podem, por exemplo, remover comentários. E questionou como seria assegurado o direito de resposta na mesma medida e alcance do conteúdo considerado inadequado nesses casos.

Política do Google A gerente de políticas públicas do Google no Brasil, Juliana Nolasco Ferreira, também considerou excessivo o artigo 12 da proposta. Em sua opinião, a obrigação de notificar o usuário não deveria existir no caso de denúncia.

Ela garantiu aos parlamentares que a empresa já está alinhada aos objetivos da lei e que já “leva a sério o compromisso de combate à desinformação”, elaborando relatórios de transparência, por exemplo, conforme previsto pelo projeto.

Segundo Juliana, no YouTube (plataforma de vídeo do Google), são aplicados os seguintes princípios: remover conteúdos que violem políticas de uso da plataforma; recomendar conteúdos de qualidade; reduzir disseminação de conteúdos duvidosos ou prejudiciais; e recompensar criadores confiáveis.

Para a remoção, os conteúdos são identificados por máquinas e revisados por humanos, e os usuários também podem sinalizar conteúdos que violem os termos de uso. Juliana reconhece, no entanto, que o processo não é isento de erros, e, neste caso, o usuário pode recorrer, e o vídeo ser reincluído.

“No primeiro trimestre de 2020, 6,1 milhões de vídeos foram removidos do YouTube, mais da metade deles relacionados a spam, práticas enganosas e golpes e segurança infantil”, informou. E, segundo ela, 49% desses conteúdos foram removidos antes da primeira visualização.

Punição Para o professor Rony Vainzof, especialista em direito digital, a Justiça não deve ser a porta de entrada para todas as decisões sobre remoção de conteúdos e de contas, e deve se limitar a resolver controvérsias.

Na visão dele, a lei deve obrigar as plataformas a ter mecanismo para garantir o contraditório e a ampla defesa e ter regras para remoção de contas inautênticas, por exemplo – conforme já consta no PL 2630/20.

Ele defendeu ainda a previsão legal de novos tipos penais para punir quem financia a desinformação em escala industrial – o que hoje não está no texto.

Gustavo Sales/Câmara dos Deputados

Lei de combate às Fake News. Dep. Margarete Coelho (PP PI)

Deputada Margarete Coelho defendeu a autorregulamentação das plataformas, direcionada pela lei

Para Vainzof, a lei deve criar obrigações mínimas para as plataformas, e o restante das regras deve ficar para uma “autorregulação regulada” – por exemplo, para um código de conduta.

O projeto em análise na Câmara prevê a elaboração desse código pelo Conselho de Transparência e Responsabilidade na Internet, que será instituído pelo Congresso, com participação dos setores públicos, privado, da sociedade civil e da academia.

A deputada Margarete Coelho (PP-PI) também acredita que a autorregulação pelas plataformas – regulamentada pela lei – é a forma mais eficiente para coibir a desinformação e proteger a democracia. Ela salientou ainda que hoje a legislação brasileira já oferece meios para busca de reparação aos danos à honra pessoal.

Reportagem – Lara HajeEdição – Natalia Doederlein

-

Áudio da matéria

Ouça esta matéria na Rádio Câmara